なぜ今、金融業界で生成AIの導入が加速しているのか?

金融業界は今、大きな変革期を迎えており、その中心にあるのが生成AIです。従来の課題であった膨大なデータの処理や高度なリスク分析、さらには顧客一人ひとりに合わせたサービスの提供を可能にする技術として、導入が急速に進んでいます。本セクションでは、なぜ今、多くの金融機関が生成AIに注目し、その導入を加速させているのか、具体的な理由を深掘りします。

圧倒的な業務効率化とコスト削減の実現

金融業界では、融資審査の書類確認や市場レポート作成、コンプライアンスチェックといった膨大な事務処理が大きな負担となっています。生成AIは、これらの定型業務を自動化することで、従業員をより付加価値の高い戦略的な業務へシフトさせます。例えば、AIが稟議書のドラフトを数分で作成したり、顧客からの問い合わせに24時間対応する高度なチャットボットを構築したりすることが可能です。さらに、複雑な規制文書の要約や不正取引のモニタリングといったコンプライアンス業務を高度化し、関連コストとリスクを大幅に削減。これにより、劇的な業務効率化と人件費の削減が実現できるのです。

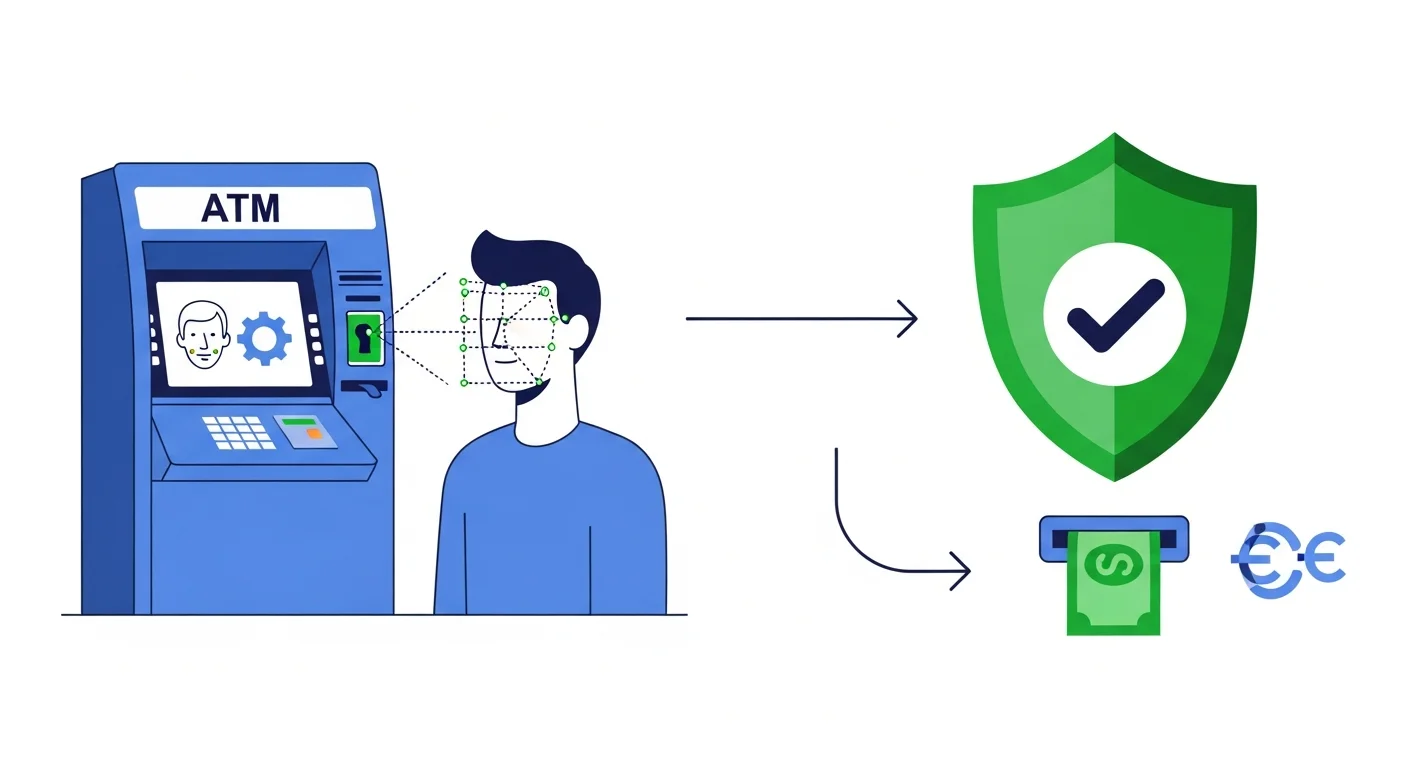

パーソナライズ化による顧客体験の向上

金融業界では顧客のニーズが多様化し、画一的なサービスでは満足度を得にくくなっています。そこで生成AIは、顧客の取引履歴やWeb行動データといった膨大な情報を解析し、一人ひとりの資産状況やライフステージに最適化された金融商品を提案します。これにより、従来は一部の富裕層に限られていたオーダーメイドに近い金融アドバイスを、より多くの顧客へ提供することが可能になります。例えば、AIチャットボットが対話を通じて顧客のリスク許容度を把握し、個別の投資ポートフォリオを即座に提示するなど、顧客はいつでも自分に合ったサポートを受けられます。このきめ細やかな対応が、顧客エンゲージメントを飛躍的に高める鍵となります。

高度なデータ分析でリスク管理を強化

金融業界では、市場の複雑化とデータの爆発的増加により、従来のリスク管理手法が限界に達しています。生成AIは、この課題を解決する強力なツールです。AIは膨大な取引履歴から正常パターンを学習し、不正取引や市場の異常な兆候をリアルタイムで検知します。さらに、過去の金融危機データをもとに、将来起こりうる精緻なリスクシナリオを複数生成し、ストレステストの精度を向上させます。ニュースやSNSなどの非構造化データを分析して市場センチメントを評価に加えることも可能で、より多角的で深層的なリスク管理を実現し、金融機関のレジリエンスを強化します。

金融業界が直面する生成AI導入の3大リスク

金融業界で業務効率化の切り札として注目される生成AIですが、その導入は諸刃の剣です。利便性の裏には、事業継続を揺るがしかねない重大なリスクが潜んでいます。このセクションでは、特に警戒すべき「情報セキュリティ」「コンプライアンス」「AIの信頼性」という3つの観点から、金融機関が直面する具体的なリスクを詳しく解説します。

機密情報の漏洩とセキュリティの脆弱性

金融業界における生成AIの利用では、顧客の個人情報や未公開の財務データといった機密情報の漏洩が最大の懸念点です。従業員がプロンプトに機密データを入力することで、意図せず外部のAIモデルの学習データとして送信・悪用されるリスクがあります。また、AI自体がサイバー攻撃の標的となり、内部情報を不正に引き出される可能性も否定できません。

これらのリスクに対処するためには、インターネットから隔離された閉域網で利用できるプライベートAI環境の構築が極めて重要です。さらに、入力情報を自動でマスキング・匿名化する技術の導入や、厳格なアクセス権限管理と従業員へのセキュリティ教育を徹底し、組織全体で情報資産を守る体制を整えることが不可欠です。

AIの誤情報が招く不適切な金融アドバイス

生成AIは、学習データに存在しない情報や古い情報をもとに、もっともらしい嘘(ハルシネーション)を生成するリスクを抱えています。金融アドバイスの文脈でこれが発生すると、存在しない金融商品を推奨したり、誤った市況分析に基づいた投資判断を促したりする可能性があります。このような不適切なアドバイスは、顧客に直接的な金銭的損害を与えるだけでなく、金融機関の信頼を著しく損ないます。対策として、AIが生成した内容は必ず専門家がファクトチェックを行う体制の構築が不可欠です。さらに、回答の参照元を明記させ、信頼性の高い金融データベースや規制当局の公式情報のみを参照するようシステムを設計することが、リスク管理の鍵となります。

複雑な法規制とコンプライアンス違反の懸念

金融機関は、個人情報保護法や金融商品取引法といった極めて厳格な規制下で運営されています。生成AIの導入は、これらのコンプライアンス遵守を一層複雑化させるリスクを内包します。例えば、AIが生成したマーケティング文言が、金商法で禁止される「断定的判断の提供」に抵触する恐れがあります。また、AIの学習プロセスで顧客の機密情報が意図せず外部に漏洩すれば、重大な法令違反に繋がります。このリスクに対応するには、AIの生成物を必ずコンプライアンス部門が承認するワークフローを構築し、AIの判断根拠を記録・追跡して当局への説明責任を果たせる体制を整えることが不可欠です。

【リスク1】情報漏洩・セキュリティに関する課題

まず最初に挙げられる最も重大なリスクが、情報漏洩とセキュリティに関する課題です。巧妙化するサイバー攻撃により、不正アクセスやマルウェア感染による被害は後を絶ちません。このセクションでは、こうした外部からの脅威だけでなく、内部不正によるデータ持ち出しなど、企業が直面する具体的なセキュリティリスクを解説します。適切な対策を怠れば、企業の信用を大きく損なう事態に繋がりかねません。

巧妙化する外部からのサイバー攻撃

ランサムウェアや標的型攻撃の手口は年々巧妙化しています。近年では、取引先を装って侵入するサプライチェーン攻撃や、AIを悪用したフィッシングメールなど、識別が困難な脅威が増加。さらにテレワークの普及により、保護されていないネットワークが新たな侵入経路となっています。もはや従来の境界型防御だけでは不十分であり、「何も信頼しない」を前提とするゼロトラストセキュリティの導入が不可欠です。PCなどの端末を監視するEDR(Endpoint Detection and Response)の導入や、実践的な従業員教育を徹底し、組織全体の防御力を底上げすることが求められます。

従業員の不注意や内部不正による漏洩

外部からのサイバー攻撃だけでなく、組織内部に潜む「人的要因」による情報漏洩も深刻な経営リスクです。メールの誤送信やUSBメモリの紛失といった従業員の不注意(ヒューマンエラー)は、日常業務のいたるところに潜んでいます。また、退職者による顧客情報の持ち出しや、金銭目的の内部不正は、より甚大な被害をもたらす可能性があります。

これらのリスクを防ぐには、定期的なセキュリティ教育で従業員の意識を高めることが不可欠です。加えて、アクセス権限の最小化や操作ログを監視するシステムの導入など、技術的な対策を組み合わせることで、意図しない漏洩や不正行為を未然に防ぎ、万が一の事態にも迅速に対応できる体制を構築しましょう。

クラウドや端末の設定不備による脆弱性

クラウドサービスの普及は業務効率を向上させる一方、設定不備が深刻な情報漏洩に直結するケースが増えています。例えば、クラウドストレージのアクセス権限を誤って「公開」にしてしまったり、ファイアウォールの設定ミスで不要なポートを開放してしまったりする人為的ミスは後を絶ちません。また、テレワークで利用する端末が、会社のセキュリティ基準を満たしていないことも大きなリスクとなります。

これらの課題には、CASB (Cloud Access Security Broker) や CSPM (Cloud Security Posture Management) といったツールでクラウド設定を常時監視し、不備を自動修正する仕組みが有効です。さらにMDM (Mobile Device Management) で端末を一元管理し、セキュリティポリシーを徹底することで、脆弱性を最小限に抑えることができます。

【リスク2】ハルシネーションとアウトプットの信頼性

生成AIの回答を鵜呑みにするのは危険です。AIが抱える大きなリスクの一つに、ハルシネーション(もっともらしい嘘)と呼ばれる現象があります。これはAIが事実無根の情報を自信満々に生成してしまう問題で、アウトプットの信頼性を著しく低下させます。本セクションでは、このハルシネーションの具体的な事例と、ビジネス利用における潜在的な危険性について深掘りしていきます。

AIが嘘をつく?ハルシネーションの原因とは

AIが生成する、事実に基づかないもっともらしい情報を「ハルシネーション」と呼びます。これはAIが意図的に嘘をついているわけではありません。主な原因は、学習データの不足や偏り、そしてAIの仕組みそのものにあります。AIは単語の出現確率に基づいて文章を生成しており、事実関係を検証する能力を持っていないのです。そのため、情報が古い、あるいは専門的すぎる分野では、誤った情報を生成してしまいます。

このリスクへの対策として、AIの回答は必ず一次情報や信頼できる情報源でファクトチェックすることが不可欠です。特に統計データや固有名詞は注意が必要です。AIはあくまで「下書き」や「アイデア出し」を補助するツールと捉え、最終的な判断と責任は人間が負うという意識で活用しましょう。

誤った情報が引き起こすビジネス上の損失

AIのハルシネーションによって生成された誤情報は、ビジネスに深刻な損失をもたらします。例えば、誤った市場データに基づいてマーケティング戦略を立てれば、多額の広告費が無駄になるだけでなく、大きな機会損失につながります。また、製品の仕様や法律に関する情報に誤りが含まれていた場合、顧客からの信頼を完全に失い、最悪の場合は訴訟問題に発展するリスクさえあります。

こうした事態を防ぐためには、AIの生成物を鵜呑みにせず、必ず専門家によるファクトチェックを行う業務フローの構築が不可欠です。特に、金融や医療といった専門分野では、社内でAI利用に関する明確なガイドラインを策定し、人間の最終確認を徹底することが、リスク管理の生命線となります。

ファクトチェックで情報の真偽を見抜く方法

AIが生成した情報を鵜呑みにせず、必ずファクトチェックを行いましょう。特に、誤った情報が大きなリスクにつながる専門分野では、一次情報源の確認が不可欠です。例えば、統計データであれば政府の公的統計サイト、医療情報であれば厚生労働省や専門学会のガイドラインといった信頼性の高い情報源と照らし合わせます。

さらに、一つの情報源だけでなく、複数の信頼できるメディアや専門家の見解をクロスチェックすることも重要です。社内にファクトチェックのガイドラインを設け、専門家による監修をフローに組み込むことで、組織として品質を担保できます。AIはあくまで調査の補助ツールと捉え、最終的な真偽判断は人間が行うという意識を持ちましょう。

【リスク3】コンプライアンスと倫理的な懸念点

技術の導入には、便利な側面だけでなく、法的な落とし穴や社会的な批判につながる危険性も潜んでいます。このセクションでは、コンプライアンス(法令遵守)の観点から著作権や個人情報保護法に抵触するリスクを解説します。さらに、AIが生み出す情報の偏り(バイアス)や差別の助長といった、企業の信頼を揺るがしかねない倫理的な懸念点にも焦点を当て、具体的な対策の必要性を明らかにします。

著作権侵害や情報漏洩につながる危険性

生成AIの利用は、著作権侵害や情報漏洩といった重大なコンプライアンス違反を引き起こす可能性があります。AIは学習データに含まれる著作権で保護されたコンテンツを意図せず出力することがあり、これが著作権侵害にあたるリスクとなります。対策として、生成物は必ずコピペチェックツールや目視でオリジナリティを確認するフローを徹底しましょう。

また、プロンプトに入力した社外秘の情報や個人情報が、AIの学習データとして外部に漏洩する危険性も深刻です。これを防ぐには、機密情報を入力しない社内ガイドラインの策定と、入力データを学習に利用しないオプトアウト設定が可能なサービスの選定が不可欠です。

差別や偏見を助長する表現生成のリスク

生成AIは、学習データに含まれる社会的なバイアスを反映し、意図せず差別や偏見を助長する表現を生み出すリスクを抱えています。例えば、特定の属性に対するステレオタイプな描写や、ヘイトスピーチと見なされかねない文章が生成されれば、ブランドイメージの深刻な毀損やSNSでの炎上に直結します。特に、採用やマーケティング分野でAIを利用する場合、このリスクは法的な問題に発展しかねません。対策として、差別的表現を避けるネガティブプロンプトの活用や、生成コンテンツを必ず人間がレビューする体制の構築が不可欠です。さらに、企業独自の倫理ガイドラインを策定し、AIの利用者が遵守すべき基準を明確に定めることが、コンプライアンス上の重大なリスクを回避する鍵となります。

虚偽情報やフェイクニュース拡散の懸念

生成AIは、学習データに含まれる誤った情報や古い情報をもとに、もっともらしい虚偽のコンテンツを生成するリスクがあります。これを検証せずに公開すれば、企業が意図せずフェイクニュースの発信源となり、ブランドイメージや社会的信用を著しく損なう事態になりかねません。特に、医療や金融といったYMYL領域では、誤情報がユーザーに与える損害は計り知れません。

このリスクを回避するには、生成された文章を鵜呑みにせず、必ず専門家によるファクトチェックを行う体制が不可欠です。また、一次情報や信頼できる情報源を明記し、社内で定めたコンテンツ公開のガイドラインに沿った複数人での校閲プロセスを徹底することが、企業の信頼性を守る鍵となります。

担当者が実践すべき生成AIリスクへの具体的な対策

生成AIの業務利用を安全に進めるためには、潜在的なリスクへの備えが不可欠です。特に情報漏洩や著作権侵害、誤情報(ハルシネーション)といったリスクは無視できません。このセクションでは、担当者が明日からでも実践できる具体的なリスク対策を解説します。社内ガイドラインの策定から利用ツールの選定、従業員教育まで、企業が取るべきアクションを明確に示します。

利用ガイドラインを策定し情報漏洩を防ぐ

生成AIによる情報漏洩を防ぐためには、明確な利用ガイドラインの策定が不可欠です。まず、入力してはいけない情報を具体的に定義することが重要です。例えば、顧客の個人情報、未公開の決算情報、製造業における設計データといった機密情報は、入力禁止項目として明記しましょう。

また、利用するAIサービスは、入力データを二次学習に利用しない(オプトアウト)設定が可能なものに限定し、その手順を周知します。特に機密性の高い情報を扱う場合は、セキュリティが担保されたAPI経由での利用やクローズドな環境を原則とすることが求められます。策定したガイドラインは全従業員に周知徹底し、定期的に見直すことで、形骸化を防ぎ安全なAI活用を実現します。

生成物のファクトチェックと人の手による修正

生成AIの出力には、ハルシネーション(事実に基づかないもっともらしい情報)が含まれるリスクが常に伴います。公開前に、担当者が必ず人の手によるファクトチェックを行うプロセスを確立しましょう。

具体的には、統計データや専門的な情報について、官公庁や研究機関が発表する一次情報と突き合わせ、正確性を検証します。さらに、SEOで重視されるE-E-A-Tの観点から、AIには生成できない独自の経験談や具体的な事例を追記し、コンテンツの信頼性と価値を高めます。

最後に、コピペチェックツールでの検証と、ブランドイメージに合致した表現への修正も不可欠です。最終的な品質の責任は、AIではなく人間が負うことを忘れてはなりません。

著作権や商標権を侵害しないための確認体制

生成AIによるコンテンツが意図せず著作権や商標権を侵害するリスクを防ぐには、厳格な確認体制が不可欠です。まず、担当者はコピペチェックツールでの文章類似度チェックや、画像検索ツールを用いた類似画像の確認を徹底しましょう。特にロゴやキャラクターデザインでは、J-PlatPat(特許情報プラットフォーム)などで登録商標と重複していないかを確認する一手間が重要です。さらに、担当者任せにせず、法務部や別担当者によるダブルチェック体制を構築し、確認漏れを防ぎます。最も重要なのは、AIの生成物をそのまま利用せず、あくまで「アイデアのたたき台」として活用するという社内ルールを徹底することです。この一手間が、偶発的な権利侵害のリスクを大幅に低減させます。

まとめ

本記事では、金融業界における生成AI導入のリスクと、その具体的な対策について解説しました。

金融業界で生成AIを活用する上で、情報漏洩、ハルシネーション、コンプライアンス違反といったリスクは避けて通れません。これらのリスクを軽視すれば、顧客からの信頼を失うなど、深刻な事態を招く可能性があります。

重要なのは、リスクを正しく理解し、明確なガイドラインの策定や従業員教育といった対策を講じた上で、段階的に導入を進めることです。生成AIの恩恵を最大限に引き出すためにも、まずは自社の課題と照らし合わせながら、安全な活用方法を検討することから始めましょう。

OptiMaxへの無料相談のご案内

OptiMaxでは、製造業・物流業・建設業・金融業をはじめとする多様な業種に向けてAI導入の支援を行っており、

企業様のニーズに合わせて無料相談を実施しています。

AI導入の概要から具体的な導入事例、業界別の活用方法まで、

疑問や不安をお持ちの方はぜひお気軽にご相談ください。